Warning

Grok API登場とGemma量子化 AIモデル競争の新展開

xAIからGrok 3とGrok 3-miniのAPIが利用可能になり、GoogleからはGemma 3の量子化モデルが登場するなど、AIモデルの開発と利用環境は目まぐるしく変化しています。今回はこれらの新しい動きを中心に、最新のAIニュースをお届けします。

xAI Grok 3 & 3-mini APIが登場

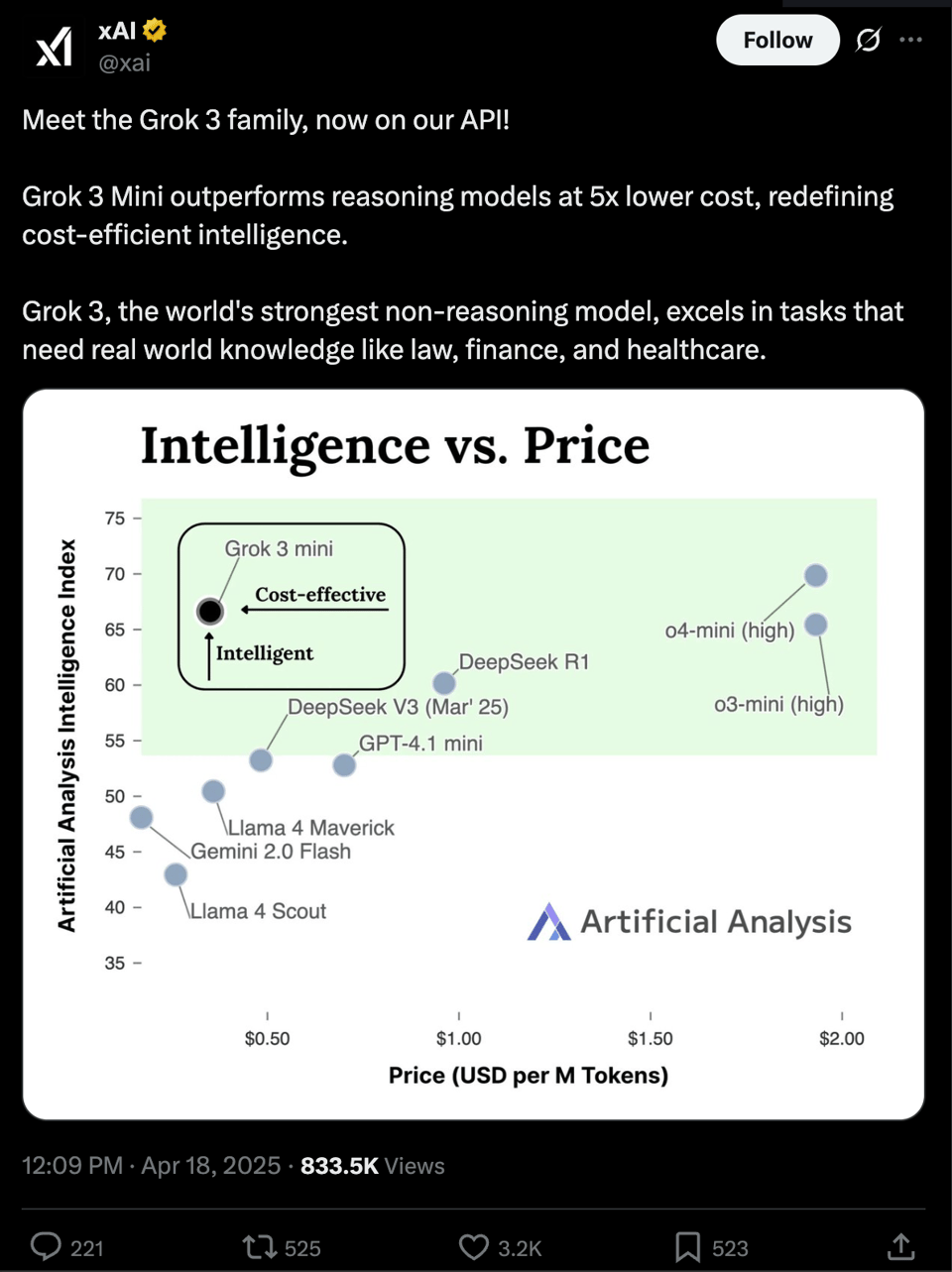

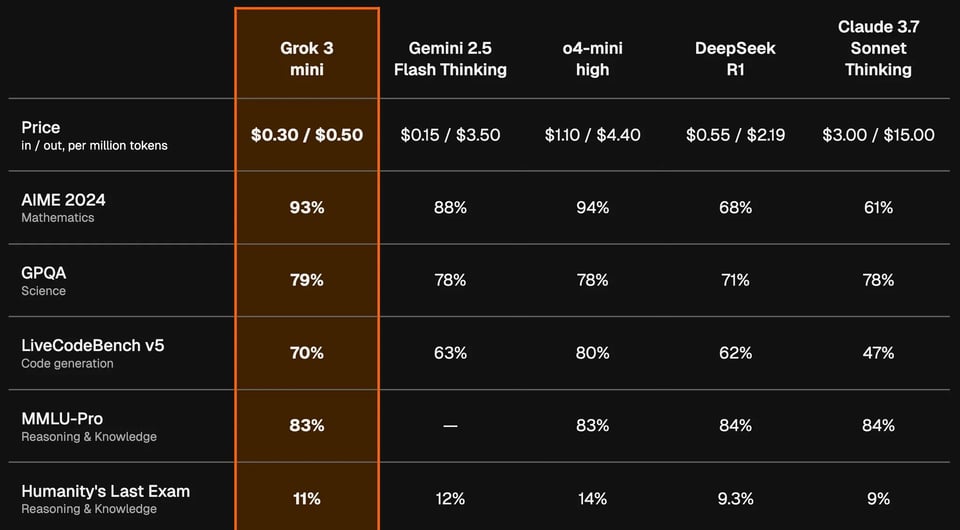

以前からその性能が注目されていたxAIのGrok 3ですが、ついにAPI経由での利用が可能になりました。さらに、より小型でコスト効率の良いGrok 3-miniも同時に提供開始されています。

Grok 3-miniは、出力トークンあたり50セントという価格設定でありながら、大規模なフロンティアモデルに匹敵する性能を持つと主張されています。特に、完全な推論トレース(思考プロセス)を表示できる点が特徴です。

Discordの議論では、Grok 3-miniがGemini 2.5 Proと比較しても、特にツール使用能力において競争力があるとの声も上がっています(ただし、ツールの呼び出しがやや積極的すぎるとの指摘も)。価格面でも、Gemini 2.5 Flashと比較して出力トークンコストが約1/7と、非常に魅力的です。

APIの利用開始はこちらのドキュメントから。 xAI Documentation

Google Gemma 3 QAT: 量子化でVRAM大幅削減

Googleは、Gemma 3モデルに対してQAT (Quantization Aware Training) を適用した新しいバージョンをリリースしました。これは、量子化による性能低下を抑えつつ、モデルのサイズとメモリ使用量を大幅に削減する技術です。

- VRAM削減効果: QAT最適化されたint4版Gemma 3 27Bモデルは、VRAM要件がbf16版の54GBから14.1GBへと劇的に減少

- これにより、RTX 3090のようなコンシューマー向けGPUでも大規模モデルの実行が容易に

- 品質維持: QATにより、量子化後もbf16に近い精度を維持

- エコシステム: 主要な推論エンジン(Ollama, llama.cpp, MLX)やプラットフォーム(Hugging Face, Kaggle)で利用可能

- 技術詳細: QATは量子化の影響を学習中にシミュレートすることで、低ビット推論時の精度低下を最小限に抑える

ただし、Redditのコミュニティでは、特定の形式(GGUFやMLX)での互換性問題や、期待されたほどのトークン生成速度が出ないといった報告も一部で見られます。また、公式のQAT GGUFモデルが特定の最適化(imatrix量子化など)を使用していない点も指摘されており、コミュニティによる更なる最適化の試みも行われています。

新しいLLMベンチマークとモデル

LLMの能力を測る新しい試みも登場しています。

- VideoGameBench: LLMに古典的なDOS/GBゲーム(DOOM IIなど)をリアルタイムでプレイさせるベンチマーク (Project Page, GitHub)

- GPT-4o, Claude Sonnet 3.7, Gemini 2.5 Pro/Flashなどがテストされたが、いずれもDOOM IIの最初のレベルすらクリアできず

- 現行のVLM(Vision-Language Model)が、動的なリアルタイム環境でのインタラクティブな推論や計画能力に限界があることを示唆

- CSM 1B TTS: オープンソースのテキスト読み上げモデルがリアルタイムストリーミングとLoRAによるファインチューニングに対応 (GitHub)

- ローカルでのリアルタイムチャットデモも実装

- Apple Siliconでの動作やリアルタイム化の最適化手法に関心が集まる

- Microsoft MAI-DS-R1: MicrosoftがDeepSeek R1をベースにポストトレーニングしたモデル (Hugging Face)

- 特にコード補完ベンチマークで高い性能を発揮

- 安全性向上やバイアス軽減のためのデータセット(Tulu 3 SFT, 内部データ)を利用

- 大規模なポストトレーニングの事例として注目

ローカルAIツールとコミュニティ動向

ローカル環境で動作するAIツールや、関連するコミュニティの動きも活発です。

- Clara: Ollamaとn8n(ワークフロー自動化ツール)を統合したローカルファーストAIアシスタント (GitHub)

- APIキーやクラウドサービス不要で、メール、カレンダー、DB操作などを自動化

- OpenAIの本人確認強化への懸念: OpenAIが最新モデルへのアクセスに際し、生体情報を含む詳細な個人情報を要求するようになったことに対し、プライバシー懸念の声が上がる

- 代替としてAnthropicやローカルモデルを推奨する意見も

- GPT-2 Attention可視化ツール: GPT-2の全アテンション重み行列をインタラクティブに視覚化するツールが登場 (Tool Link)

- モデルの内部動作理解に貢献

- Grok 2オープンソース化の遅延: xAIが約束していたGrok 2のオープンソース化が遅れていることについて、リリース時には性能的に時代遅れになっているのでは?との議論

- Grok 1のリリースタイミングを踏まえた懸念

OpenAI o3 / GPT-4o の性能と挙動

OpenAIの最新モデルo3やGPT-4oについても、様々な利用例や評価が報告されています。

- 驚異的な地理空間認識 (o3): GeoGuessrにおいて、雪景色のような手がかりの少ない画像から、メタデータなしで正確な場所(ウズベキスタンのスキーリゾートなど)を特定する能力を発揮

- Gemini 2.5 Proも同様のタスクで成功しており、最新VLMの画像認識能力の高さを示す

- ビジネスアドバイザーとしてのo3: スタートアップ創業者などから、従来のモデル(GPT-4.5など)よりも指示的で権威のあるアドバイスをするとの評価

- 単なる仮説生成に留まらず、具体的な行動計画(MVPのリリースとデータに基づく改善)を提示

- 一方で、コード出力が約200行に制限される点や、誤った情報を自信を持って提示する場合があるとの指摘も

- 単純な誤答と再現性 (o3): 「strawberry」という単語に含まれる「r」の数を間違える(正しくは3つなのに2つと回答)といった基本的な誤りが報告されるケースも

- ただし、他のユーザーが試すと再現しないことが多く、一時的な不具合や特定のセッションの問題である可能性も

- 一部の報告では、応答時に通常表示される「Thinking」表示がなかったとの指摘もあり、UIやバックエンドの異常も示唆

その他の注目技術・業界動向

- Seedream 3.0: ByteDanceによる新しい画像生成モデル。Artificial AnalysisのArenaベンチマークでGPT-4oと並びトップ評価を獲得 (Technical Details, Arena Leaderboard)

- ただし、ベンチマークの更新頻度や評価基準について疑問視する声も

- arXivのGoogle Cloud移行: 著名なプレプリントサーバーarXivが、インフラをCornell大学のオンプレミスからGoogle Cloud Platformへ移行中 (Hiring Page)

- 大規模なコードベース書き換えと同時に行うことのリスクや、GCPへのベンダーロックインを懸念する声

- OpenAI Flex Pricing: API利用料を50%削減する代わりに、需要が高い場合にレスポンスが遅延する可能性がある新しい価格帯 (OpenAI Documentation)

- 既存のBatch APIとの違いや、具体的な遅延レベルについて開発者から質問が上がる

- Agent2Agent (A2A) プロトコル: Googleなどが推進する、AIエージェント間の安全な情報交換や連携のためのオープンプロトコル

- LlamaIndexなどが対応を表明 (LlamaIndex Tweet)

- Quantization (Embzip, QAT): 埋め込みベクトルを効率的に圧縮するライブラリEmbzip (jxmnop Tweet)や、前述のGemma 3 QATなど、モデル軽量化技術が進化

- vLLMとHugging Face Transformers統合: 高速推論ライブラリvLLMでHugging Faceの言語モデルを容易にデプロイ可能に (vLLM Tweet)

- Perplexity AIの進化: Telegramボット提供開始、APIでの画像アップロード・日付フィルター対応、引用トークン料金廃止など、機能拡充が進む

まとめ

xAIのGrok API提供開始やGoogleのGemma 3 QATによる量子化技術の進展は、高性能AIモデルへのアクセス性と効率性を大きく向上させる動きと言えます。一方で、VideoGameBenchのような新しい評価軸は、現行モデルの限界も浮き彫りにしています。

ローカル環境で動作するAIツールや、モデルの内部を可視化する試み、エージェント間連携プロトコルなど、AIを取り巻くエコシステムも多様化・深化しています。OpenAIのo3/GPT-4oは高い能力を示していますが、その挙動や信頼性については引き続き注目が必要です。

モデル開発競争、インフラ整備、そしてユーザー体験の向上が、今後もAI分野の進化を加速させていくでしょう。